サマリー

インシデント ポイントまたは重み付きフィーチャ (ポイントまたはポリゴン) に基づいて、Getis-Ord Gi* 統計を使用し、統計的に有意なホット スポットとコールド スポットのマップを作成します。最適な結果を得るために、入力フィーチャクラスの特性が評価されます。

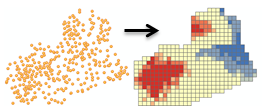

図

使用法

このツールは、統計的に有意な高い値および低い値の空間クラスター (ホット スポットとコールド スポット) を特定します。自動的にインシデント データが集約され、適切な分析のスケールが決定され、多重検定と空間依存性の両方に対して補正されます。このツールは、最適なホット スポット分析結果が得られる設定を決めるために、データを調べます。これらの設定を完全に制御したい場合は、代わりに [ホット スポット分析 (Hot Spot Analysis)] ツールを使用してください。

-

最適なホット スポット分析結果を得るために使用された、計算された設定は、[結果] ウィンドウにレポートされます。関連するワークフローとアルゴリズムが、「最適化ホット スポット分析 (Optimized Hot Spot Analysis) の詳細」で説明されています。

このツールは、入力フィーチャクラスの各フィーチャの Z スコア、p 値、および信頼度ビン (Gi_Bin) を含む新しい出力フィーチャクラスを作成します。

Gi_Bin フィールドは、統計的に有意なホット スポットとコールド スポットを特定し、FDR (False Discovery Rate) 補正を使用して多重検定と空間依存性に対して補正されます。+/-3 ビンのフィーチャ (Gi_Bin の値が +3 または -3 のフィーチャ) は、99% の信頼度で統計的に有意です。+/-2 ビンのフィーチャは、95% の信頼度を反映します。+/-1 ビンのフィーチャは、90% の信頼度を反映します。Gi_Bin フィールドが 0 のフィーチャのクラスターは、統計的に有意ではありません。

Z スコアおよび p 値のフィールドは、どの種類の FDR (False Discovery Rate) 補正も反映しません。Z スコアと p 値の詳細については、「Z スコアと p 値」をご参照ください。

[入力フィーチャクラス] が投影されていない場合 (つまり、座標が、度、分、および秒で与えられた場合)、または出力座標系が地理座標系に設定された場合、弦の測定値を使用して距離が計算されます。少なくとも互いに約 30°の範囲内のポイントに対して、すばやく計算することができ、真の測地距離の非常に優れた推定値が得られるため、弦距離の測定値が使用されます。弦距離は、短回転楕円体に基づいています。地球の表面上の 2 点が与えられた場合、2 点間の弦の距離は、3 次元の地球内部を通過して 2 点を接続するラインの長さになります。弦距離は、メートル単位でレポートされます。

入力フィーチャはポイントまたはポリゴンである場合があります。ポリゴンの場合、[分析フィールド] は必須です。

[分析フィールド] を指定する場合、さまざまな値を含める必要があります。この統計計算では、分析する変数に変異が存在する必要があります。たとえば、入力値がすべて 1 の場合、解は存在しません。

このツールは、[分析フィールド] で指定された、サンプリングされたデータを含むあらゆるデータ (ポイントまたはポリゴン) を適切に処理できます。実際、このツールは、オーバーサンプリングが存在する場合でも効果的であり、信頼できます。フィーチャの数が多い場合 (オーバーサンプリング)、ツールは、正確で信頼できる結果を計算するための多くの情報を得ることができます。フィーチャの数が少ない場合 (アンダーサンプリング) でも、ツールは、正確で信頼できる結果を生成するために、可能なことをすべて実行します。ただし、処理される情報は少なくなります。

このツールが内部で使用する Getis-Ord Gi* 統計は漸近正規性を持つため、歪みのあるデータが [分析フィールド] に含まれる場合でも、結果は信頼できます。

ポイント データでは、各ポイント フィーチャに関連付けられたデータ値の解析に関心がある場合があります。その場合、[分析フィールド] を指定します。その他のケースでは、ポイントの位置またはポイント インシデントの空間パターン (クラスタリング) を評価することのみが必要になります。[分析フィールド] を指定するかどうかは、質問の内容によって変わります。

- [分析フィールド] を使用してポイント フィーチャを分析することで、次のような質問に答えることができます。高い/低い値のクラスターはどこか。

- 選択する分析フィールドは以下のいずれかを表します。

- 個数 (交差点での交通事故件数など)

- 比率 (都市の失業率など。ここで各都市は、ポイント フィーチャで表されます)

- 平均 (学校間のテスト スコアの平均計算など)

- インデックス (郡の車の販売代理店に関する顧客満足度など)

- [分析フィールド] がない場合にポイント フィーチャを分析することで、ポイントのクラスタリングが異常 (統計的に有意な程度) に密集しているかまばらな場所を識別できます。この種の分析は、「多くのポイントが存在する場所はどこか」、「ポイントが非常に少ない場所はどこか」のような質問に答えることができます。

[分析フィールド] を指定しない場合、このツールは、分析フィールドとして使用するポイント数を得るために、ポイントを集約します。以下の 3 種類の集約方法を指定できます。

- COUNT_INCIDENTS_WITHIN_FISHNET_POLYGONS の場合、適切なポリゴン セル サイズが計算されて、フィッシュネット ポリゴン メッシュの作成に使用されます。フィッシュネットがインシデント ポイント上に配置され、各ポリゴン セル内のポイント数が計算されます。[インシデント範囲境界ポリゴン] フィーチャ レイヤーを指定しない場合、ポイント数がゼロのフィッシュネット セルが削除され、残りのセルのみが分析されます。境界ポリゴン フィーチャ レイヤーを指定した場合、境界ポリゴンに含まれるすべてのフィッシュネット セルが保持されて、分析されます。各ポリゴン セルのポイント数は、分析フィールドとして使用されます。

- COUNT_INCIDENTS_WITHIN_AGGREGATION_POLYGONS の場合、[インシデント集約境界ポリゴン] フィーチャ レイヤーを指定する必要があります。各ポリゴンに含まれるポイント インシデント数が計算されます。関連するカウントを含めたこれらのポリゴンが、分析されます。COUNT_INCIDENTS_WITHIN_AGGREGATION_POLYGONS は、ポイントが行政地名 (地域、群、学区など) に関連する場合に適した集約方法です。比較操作を強化するために、複数の分析にまたがって分析範囲を固定したい場合にも、このオプションを使用できます。

- SNAP_NEARBY_INCIDENTS_TO_CREATE_WEIGHTED_POINTS の場合、スナップ距離が計算され、近傍のインシデント ポイントの集約に使用されます。集約された各ポイントには、一緒にスナップされたインシデントの数を反映するカウントが与えられます。次に、集約されたポイントは、インシデント数を分析フィールドとして使用して分析されます。SNAP_NEARBY_INCIDENTS_TO_CREATE_WEIGHTED_POINTS は、多くのポイントが同じ位置または近い位置にあり、元のポイント データの空間パターンの特徴を維持したい場合に適した集約方法です。多くの場合、SNAP_NEARBY_INCIDENTS_TO_CREATE_WEIGHTED_POINTS と COUNT_INCIDENTS_WITHIN_FISHNET_POLYGONS の両方を試してみて、どちらの結果が元のポイント データの空間パターンをよく反映しているかを確認したほうがよいでしょう。フィッシュネットによる方法は、ポイント インシデントのクラスターを人為的に分割しますが、人によっては、重み付きポイントの出力よりも、この出力の方が解釈しやすいことがあります。

-

インシデント データ集約方法として COUNT_INCIDENTS_WITHIN_FISHNET_POLYGONS を選択した場合、オプションで [インシデント範囲境界ポリゴン] フィーチャ レイヤーを指定できます。境界ポリゴンを指定しないと、ツールは、インシデントのない場所をゼロに設定して、インシデントが発生する可能性があるが発生していないことを示すべきかどうかを判断できず、インシデントが発生する可能性がない場所を分析から削除するべきかどうかを判断することもできません。その結果、境界ポリゴンを指定しない場合、1 つ以上のインシデントを含むフィッシュネット セルのみが分析の対象として保持されます。このような動作を望まない場合は、境界ポリゴン内のすべての場所を確実に保持するように、[インシデント範囲境界ポリゴン] フィーチャ レイヤーを指定できます。インシデントを含まないフィッシュネット セルには、インシデント数としてゼロが与えられます。

インシデント範囲境界ポリゴンにもインシデント集約境界ポリゴンにも含まれないインシデントは、すべて分析から除外されます。

-

ArcGIS Spatial Analyst が存在する場合、ポイント入力フィーチャの密度サーフェスを作成できます。[分析フィールド] を指定した場合、または [インシデント データ集約方法] で SNAP_NEARBY_INCIDENTS_TO_CREATE_WEIGHTED_POINTS を選択した場合、ポイント入力フィーチャでは、[密度サーフェス] パラメーターを有効にできます。出力密度サーフェスは、環境設定で指定したラスター分析マスクにクリップされます。ラスター マスクを指定しない場合、出力ラスター レイヤーは、入力フィーチャの周囲の凸包にクリップされます。

時空間ホット スポットを特定する場合は、[空間ウェイト マトリックスの生成 (Generate Spatial Weights Matrix)] ツールおよび [ホット スポット分析 (Hot Spot Analysis (Getis-Ord Gi*))] ツール使用する必要があります。時空間クラスター分析については、「時空間クラスター分析」のトピックをご参照ください。

-

マップ レイヤーを使用して、入力フィーチャクラスを指定できます。解析対象として指定したレイヤーの中で何らかのフィーチャが選択されている場合、選択されているフィーチャだけが解析の対象となります。

-

出力フィーチャ レイヤーは自動的に [コンテンツ] ウィンドウに追加され、Gi_Bin フィールドにはデフォルトのレンダリングが適用されます。ホットからコールドへのレンダリングは、<ArcGIS>/Desktop10.x/ArcToolbox/Templates/Layers にあるレイヤー ファイルによって定義されます。必要に応じて、テンプレート レイヤー シンボルをインポートすれば、デフォルトのレンダリングを再適用できます。

構文

OptimizedHotSpotAnalysis_stats (Input_Features, Output_Features, {Analysis_Field}, {Incident_Data_Aggregation_Method}, {Bounding_Polygons_Defining_Where_Incidents_Are_Possible}, {Polygons_For_Aggregating_Incidents_Into_Counts}, {Density_Surface})| パラメーター | 説明 | データ タイプ |

Input_Features | ホット スポット分析が実行されるポイント フィーチャクラスまたはポリゴン フィーチャクラス。 | Feature Layer |

Output_Features | Z スコア、p 値、および Gi_Bin の結果を受け取る出力フィーチャクラス。 | Feature Class |

Analysis_Field (オプション) | 評価する数値フィールド (インシデント数、犯罪率、テストのスコアなど)。 | Field |

Incident_Data_Aggregation_Method (オプション) | インシデント ポイント データから分析するための重み付きフィーチャの作成に使用される集約方法。

| String |

Bounding_Polygons_Defining_Where_Incidents_Are_Possible (オプション) | インシデントInput_Featuresが発生する可能性のある場所を定義するポリゴン フィーチャクラス。 | Feature Layer |

Polygons_For_Aggregating_Incidents_Into_Counts (オプション) | ポリゴン フィーチャごとのインシデント数を取得するために、インシデントInput_Featuresの集計に使用されるポリゴン。 | Feature Layer |

Density_Surface (オプション) | ポイント入力フィーチャの出力密度サーフェス。このパラメーターは、Input_Features がポイントであり、ArcGIS Spatial Analyst が存在する場合にのみ有効化されます。作成された出力サーフェスは、環境設定で指定したラスター分析マスクにクリップされます。ラスター マスクを指定しない場合、出力ラスター レイヤーは、入力フィーチャの凸包にクリップされます。 | Raster Dataset |

コードのサンプル

OptimizedHotSpotAnalysis (最適化ホット スポット分析) の例 1 (Python ウィンドウ)

次の Python ウィンドウ スクリプトは、OptimizedHotSpotAnalysis (最適化ホット スポット分析) ツールの使用方法を示しています。

import arcpy

arcpy.env.workspace = r"C:\OHSA"

arcpy.OptimizedHotSpotAnalysis_stats("911Count.shp", "911OptimizedHotSpots.shp", "#", "SNAP_NEARBY_INCIDENTS_TO_CREATE_WEIGHTED_POINTS", "#", "#", "calls911Surface.tif")

OptimizedHotSpotAnalysis (最適化ホット スポット分析) の例 2 (スタンドアロン Python スクリプト)

次のスタンドアロン Python スクリプトは、OptimizedHotSpotAnalysis (最適化ホット スポット分析) ツールの使用方法を示しています。

# Analyze the spatial distribution of 911 calls in a metropolitan area

# Import system modules

import arcpy

# Set property to overwrite existing output, by default

arcpy.env.overwriteOutput = True

# Local variables...

workspace = r"C:\OHSA\data.gdb"

try:

# Set the current workspace (to avoid having to specify the full path to the feature classes each time)

arcpy.env.workspace = workspace

# Create a polygon that defines where incidents are possible

# Process: Minimum Bounding Geometry of 911 call data

arcpy.MinimumBoundingGeometry_management("Calls911", "Calls911_MBG", "CONVEX_HULL", "ALL",

"#", "NO_MBG_FIELDS")

# Optimized Hot Spot Analysis of 911 call data using fishnet aggregation method with a bounding polygon of 911 call data

# Process: Optimized Hot Spot Analysis

ohsa = arcpy.OptimizedHotSpotAnalysis_stats("Calls911", "Calls911_ohsaFishnet", "#", "COUNT_INCIDENTS_WITHIN_FISHNET_POLYGONS",

"Calls911_MBG", "#", "#")

except:

# If any error occurred when running the tool, print the messages

print(arcpy.GetMessages())

環境

ライセンス情報

- ArcGIS Desktop Basic: はい

- ArcGIS Desktop Standard: はい

- ArcGIS Desktop Advanced: はい